👉 Ce qu’il faut retenir…

- Les neurones artificiels sont les unités de base qui imitent le fonctionnement du cerveau humain dans les systèmes d’IA.

- Les réseaux de neurones, en reliant ces unités, permettent aux machines d’apprendre des tâches complexes.

- L’apprentissage profond (Deep Learning) a permis des avancées spectaculaires grâce à la multiplication des couches de neurones.

- En 2017, Google a introduit les « transformers », une innovation clé qui est à l’origine des IA génératives modernes.

De la naissance des neurones artificiels aux transformers

L’intelligence artificielle actuelle prend racine dans une série d’évolutions technologiques fascinantes. Cet article explore comment l’idée simple du neurone artificiel a mené à la révolution des transformers en 2017.

Les origines : Neurone artificiel et perceptron

Le concept de neurone artificiel remonte aux années 1950. S’inspirant du système cérébral des animaux, ce modèle mathématique simule un unique neurone biologique. Le fameux perceptron, développé par Frank Rosenblatt, est un exemple classique de cette idée. Il s’agit d’un algorithme capable d’apprendre et de prendre des décisions basées sur des données en ajustant ses poids internes.

Malgré sa simplicité apparente, le perceptron pose les bases pour comprendre comment une machine peut « apprendre ». Imaginez-le comme un petit engrenage dans une grande machine cognitive !

Du perceptron aux réseaux de neurones

Si un seul perceptron peut résoudre certaines tâches simples, il devient rapidement limité face à la complexité croissante du monde réel. C’est là qu’interviennent les fameux réseaux de neurones : ils connectent plusieurs perceptrons pour former un système capable d’analyser plus finement l’information.

Ces réseaux sont capables non seulement de reconnaître des motifs simples mais aussi complexes grâce à leurs couches cachées intermédiaires où chaque couche affine progressivement l’information reçue. En gros ? C’est comme passer votre café préféré au filtre jusqu’à obtenir votre tasse parfaite ☕️!

L’avènement du Deep Learning

Dans cette quête incessante pour améliorer l’efficacité cognitive de nos machines (ou ennemies, si l’on en croit Terminator), est apparu ce que nous appelons aujourd’hui « l’apprentissage profond ». Cela revient essentiellement à ajouter encore plus de couches de neurones… mais pas n’importe comment !

L’une des forces du deep learning réside en effet dans la spécialisation de ses couches de neurones. Par exemple, dans les réseaux neuronaux convolutifs utilisés pour la reconnaissance d’images : certaines couches se concentrent sur la détection de lignes à partir d’un ensemble de pixels, d’autres identifient des formes à partir de ces lignes, et enfin certaines reconnaissent des objets complets à partir des formes. Alimenté par des GPU puissants (👋NVidia) capables de traiter simultanément un grand volume de données, le deep learning a permis un essor spectaculaire d’applications comme la reconnaissance vocale ou visuelle.

Les Transformers : Révolution discrète mais puissante (2017)

Et alors que tout semblait déjà bien abouti , voici venue année charnière – Roulement de tambour – : 2017 . Google publie un article révolutionnaire intitulé « Attention Is All You Need » présentant une architecture radicalement nouvelle appelée TRANSFORMER.

Contrairement aux architectures « deep learning » précédentes nécessitant un ordonnancement strict et séquentiel entre des couches de traitement successives, le transformer repose sur un mécanisme « d’attention » qui permet de traiter les informations de manière parallèle, donc plus rapide et efficace. En accélérant considérablement les capacités d’apprentissage, cette approche a entièrement bouleversé le domaine, notamment dans la génération de texte, d’images, de sons et de vidéos ! (On arrive à ChatGPT…)

Aujourd’hui, les transformers sont à la base de tous les LLMs (grands modèles de langage) qui suscitent un vif intérêt. Des modèles comme GPT-3, GPT-4, et d’autres tels que Mistral ou Gemini dominent le marché des chatbots et assistants personnels. Ironiquement, bien que Google ait initié cette révolution avec sa découverte en 2017, il n’a pas pleinement capitalisé sur cet engouement… Comme quoi même les pionniers peuvent être dépassés ! 😅

✔ Pour aller plus loin…

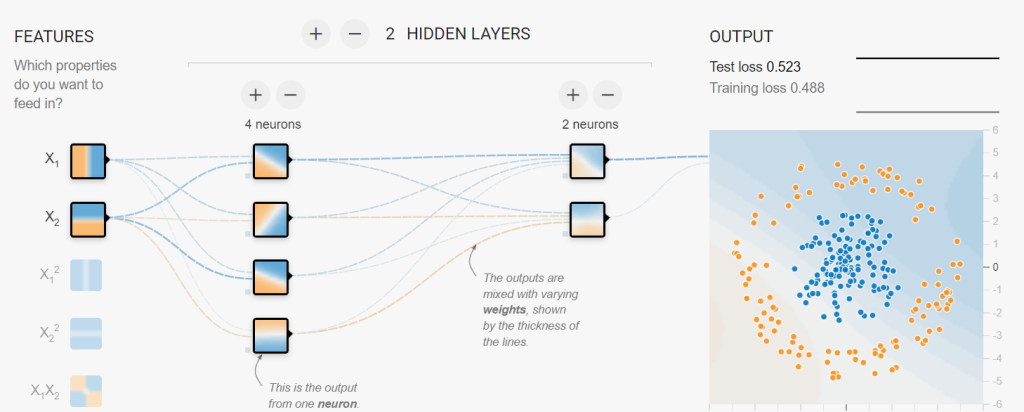

- Les neurones artificiels ne cessent d’évoluer, avec des innovations qui repoussent constamment les frontières de l’IA. Pour ceux qui veulent voir et interagir avec un réseau de neurones en action (et sans une ligne de code), essayez le playground de Tensorflow.

- Si vous vous êtes découvert une passion pour les transformers, cet article en anglais permettra d’approfondir vos connaissances.

Passionné d’intelligence artificielle depuis près de 5 ans, j’aide les entreprises troyennes à exploiter son potentiel. L’IA offre désormais tellement de possibilités que chaque seconde perdue est une occasion manquée de prendre de l’avance.